第1回 Kobe.R annex(犬4匹本 輪読会)開催しました!

2017年9月24日 大阪府立大学・なんばサテライトにて Kobe.R annex 第1回を開催しました。第1部『ベイズ統計モデリング―R,JAGS,Stanによるチュートリアル― 原著第2版』の輪読,第2部 分析ネタなんでもという構成でした。参加者は5名(+会場をご提供いただいた大阪府立大学の先生)。

予定は第6章〜9章の予定だったのですが,8章までとしました。もちろん全員,犬4匹本を購入済みです。以下,輪読会の簡単メモです。

第7章

- JAGS の情報が載っていてわかりやすいウェブサイトがある。

http://ecological-stats.com/tag/jags/

- MCMCスライド集

追加情報: 警告メッセージ: 命令 ''/Library/Frameworks/R.framework/Resources/bin/R' CMD config CXX 2>/dev/null' の実行は状態 69 を持ちました

追加情報: 警告メッセージ: 命令 '/Library/Frameworks/R.framework/Resources/bin/R CMD SHLIB file8dae4ce1404e.cpp 2> file8dae4ce1404e.cpp.err.txt' の実行は状態 1 を持ちました

疑問点

- Gelman-Rubin統計量(184頁)はRハットのことだろうか?

→どうやらそのようです。

- 間引き(thinning)はすべき? すべきでない?

→犬4匹本は基本thinningしない的な立場(191頁)のようだが,thinning したほうがよいという文献もあるらしい。

- thinning をした場合,サンプリング時間はどう変わるだろうか?

→あるモデルで「iteration 1000,thin 1」「iteration 1000,thin 2」「iteration 2000,thin 2」を stan で実行してみると,90秒・90秒・180秒となった。保存されたオブジェクトのデータは8MB, 4MB, 8MB。thinning の設定でサンプリング時間は変わらないが,保存されるオブジェクトの容量は変わる。

第8章

- 参加者の方が8章の便利関数をパッケージ化されました!

参加させていただき、ありがとうございました。

— ヨゼ (@kyusque) 2017年9月24日

8章の便利コマンドですが、パッケージとしてgithubに上げました。

devtools::install_github("kyusque/DBDA2E-utilities", args = "--no-multiarch")

LT枠(分析ネタなんでも)

状態空間モデルについて

共変量バランシング傾向スコアを使った統計的因果推論について

以上です。次回もいずれ開催したいと思います。

Proximity Matching による因果効果の推定?

2017年7月30日のKazutan.Rで「Proximity Matching による因果効果の推定」というタイトルで LT をしてきました。スライドは↓ですが,R のスクリプトは少なめなので,その補足説明をここに残しておこうと思います。

https://hikarugoto.github.io/kazutanR20170730/

LT の動機

今回の発表のモチベーションは,たまたま次の論考(何かの予稿集かな?)を見かけ,傾向スコアに代わる何かがあるのだったら,調べてみようかなと思った次第です。ランダムフォレストと傾向スコアについては,@TJO さんや@nakamichi さんなどがすでにブログで書いていらっしゃいますが,この論考では Proximity というのを使ってマッチングを行うものなので,ちょっと方法が違うようです。

Zhao, P., Su, X., Ge, T., & Fan, J. (2016). Propensity score and proximity matching using random forest. Contemporary Clinical Trials, 47, 85-92.

ランダムフォレストから Proximity を出して,マッチングを行う例は,すでに “Causal inference with observational data in R: A walk-through from some recent research” という YouTube 動画と資料があったので今回の LT ではそれをなぞってみました。

使用したデータ

統計的因果推論といえば,岩波データサイエンス vol.3 ! そちらのサポートページで公開されているデータを使いました。

- 作者: 岩波データサイエンス刊行委員会

- 出版社/メーカー: 岩波書店

- 発売日: 2016/06/10

- メディア: 単行本(ソフトカバー)

- この商品を含むブログ (4件) を見る

10000行で35変数ありますが,「CM視聴の有無でゲーム利用回数はどの程度異なるか」をアウトカムにして,23変数を使うことにしました。イメージ的にはこんな感じ(あんまりいい図ではないけど)。

上の図は DiagrammeR で書きました。

grViz(" digraph boxes_and_circles { # a 'graph' statement graph [overlap = true, fontsize = 10] # several 'node' statements node [shape = box, fontname = Helvetica] 原因変数(CM視聴の有無); ゲーム利用回数 node [shape = circle, width = 1] // sets as circles 共変量 # several 'edge' statements 共変量->{原因変数(CM視聴の有無) ゲーム利用回数} 原因変数(CM視聴の有無)->{ゲーム利用回数} } ")

使用したパッケージ

使ったパッケージは次のとおりです。

library(ggplot2) library(randomForest) library(dplyr) library(magrittr) library(broom) library(knitr) library(DiagrammeR) library(ggpubr)

分析の手順

まず,使用する変数を元のデータから取り出します。select で -(マイナス)を使い,不要な列を削除しました。

CI_data %<>% select(-gamedummy, -area_keihan, -job_dummy8, -fam_str_dummy5, -T:-M3, -gamesecond) CI_data %>% glimpse() Observations: 10,000 Variables: 23 $ cm_dummy <int> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ... $ area_kanto <int> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, ... $ area_tokai <int> 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ... $ area_keihanshin <int> 1, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0, 1, 0, 1, 1, 0, 0, 0, 1, 0, 0, 0, 0, ... $ age <dbl> 44.5, 34.5, 24.5, 44.5, 34.5, 24.5, 19.0, 54.5, 44.5, 34.5, 34.5, 34.5, ... <以下,省略>

%<>% はあまり見かけませんが,左からデータフレームを右に流していって,その後,同じ名前のオプジェクトに置き換える破壊的な操作をするパイプです。今回は軽い分析なので使ってみました。 2行目はチラ見関数です。str() よりもモダンな感じ?

ランダムフォレストの実行

proximity を得るために,ランダムフォレストを実行します。

cm_dummy = CI_data$cm_dummy==1 # 論理ベクトル rf = randomForest(cm_dummy ~ ., data = CI_data, proximity = TRUE) # 1分くらいかかる

1行目は CM視聴した有無を論理値ベクトルで入手し,それを randamForest で使います。なぜ,論理値ベクトルにする必要があるのか,私には不明です。proximity = T のオプションを忘れないのが重要です。

Proximity でマッチングさせたデータを作る

参考資料では,以下のようにして,マッチングを行っています。

prox = rf$proximity - diag(nrow(rf$proximity)) # 何やってるの? prox.true = prox[cm_dummy, !cm_dummy] # 何やってるの? untre.samples = apply(prox.true, 1, which.max) # 行ごとに proximity が最大の列を抜き出し? tre = CI_data[cm_dummy,] # 処置群のみ取り出し untre = CI_data[!cm_dummy,] # 対照群のデータのみ取り出し untre.samples2 = unique(untre.samples) # 重複している行を削除。 untre2 = untre[untre.samples2,] # 処置群と似ている対照群を抜き出している? whole.sample.u = rbind(tre, untre2) # それぞれのデータを結合。

もっとも重要なところなのでしょうが,勉強不足でよくわからん・・・。目をつぶって先に進みます。

共変量のバランスは取れたのかチェックしてみる。

せっかくなので,CM見た群と見なかった群の共変量の分布が近づいたかどうか,TVwatch_day と pmoney について見てみます。マッチング前後で見比べるため,ggplot で作図したものを並べます。ggplot を並べる方法はいくつかありますが,今回は ggpubr の ggarrange() を使います。

a1 = CI_data %>% ggplot(aes(x = TVwatch_day)) + geom_density(aes(colour = factor(cm_dummy) ,fill = factor(cm_dummy)), alpha = 0.5) a2 = whole.sample.u %>% ggplot(aes(x = TVwatch_day)) + geom_density(aes(colour = factor(cm_dummy) ,fill = factor(cm_dummy)), alpha = 0.5) b1 = CI_data %>% ggplot(aes(x = pmoney)) + geom_density(aes(colour = factor(cm_dummy) ,fill = factor(cm_dummy)), alpha = 0.5) b2 = whole.sample.u %>% ggplot(aes(x = pmoney)) + geom_density(aes(colour = factor(cm_dummy) ,fill = factor(cm_dummy)), alpha = 0.5)

TVwatch_day のマッチング前の密度分布(a1),マッチング後(a2)として,pmoney も同様にマッチング前後(b1 と b2)を ggplot() で作ります。並べるには次のようにggpub パッケージの ggarrange()を使います。

ggarrange(a1, a2, b1, b2, ncol = 2, nrow = 2, labels = c("Before Matching","After Matching","Before Matching","After Matching"), common.legend = TRUE)

図を2行2列で並べて,それぞれマッチング前とマッチング後のラベルをつけ,共通の凡例を表示させます。

確認しても,これで共変量が調整されているかなんとも言えないです・・・。なお,この並べ方は次のページを参考にしました。

因果効果の推定結果を確認

参考資料には「あとは回帰分析すればいいぜ」と書いてあったので,やってみます。なんか怪しい。まぁ,RCT に近づいたからやっていいという考え方だとは思うのですが・・・。

lm(gamecount ~ ., data = whole.sample.u) %>% tidy() %>% head(3) %>% kable()

lm() で得た結果を2行目でデータフレームにして,3行目ではじめの数行だけ表示させ,4行目で下の表を出すためのマークダウンを得ました。

| term | estimate | std.error | statistic | p.value |

|---|---|---|---|---|

| (Intercept) | 46.467720 | 7.462751 | 6.226621 | 0.0000000 |

| cm_dummy | 5.080259 | 1.499469 | 3.388039 | 0.0007088 |

| area_kanto | -3.428637 | 2.041777 | -1.679242 | 0.0931606 |

上の表から,CMを見た場合の平均処置効果(ATE)は 5.08 であることがわかりました。岩波DS vol.3 でIPWによってATEを出したときの結果が 5.32 ですから(96ページ),近いと言えば近い*1。

| ATE | |

|---|---|

| 岩波DS vol.3 | 5.32 |

| RF で IPW @nakamichi*2 | 5.32 |

| Proximity でマッチング | 5.08 |

分析してみた感想

やっていることをよく理解できず,今回の結果を信じるには至っていません。ちなみに傾向スコアマッチングは使わないほうがいいという論考が出ています*3。今回の方法は傾向スコアの弱点をクリアしているものの*4,IPW法など他のやり方があるので,わざわざマッチングをしなくてもいいように思いました。

最後に

やはり,Kazutan.R に参加してよかったです。主催者 kazutan 先生やハンズオンの MrUnadadon氏,LTされた方々に感謝。私にはデータ分析をする人が身近にいないので,情報の入手先は twitter やこういう勉強会がすべてなので(書籍の情報も twitter で知ることが多い),助かります。

*1:ちなみに,スライドで2.32と書いたのは ATT でまちがいでした。スミマセン

*2:https://rpubs.com/nakamichi_/study-iwanami-ds3

*3:King and Nielsen (2016)"Why Propensity Scores Should Not Be Used for Matching"

*4:Zhao らによれば,傾向スコアの限界は「model misspecifications, categorical variables with more than two levels, difficulties in handling missing data, and nonlinear relationships」とのことです。

R による整列ランク変換を使った分散分析

整列ランク変換(Aligned Rank Transform:ART)という言葉を聞いたことありますか? 私はなかったです。ART(えーあーるーてぃー。「あーと」ではない)について、Tokyo.R 第61回で LT をしてきました。補足も兼ねて ART についてまとめます。

きっかけ

先日、自分の専門分野の先行研究を調べていて論文(Heidenreich, et al. 2015)を読んでいたら次のような記述に出会いました。

“As our data were not normally distributed (D(243)=2.193, p<0.01), we employed the aligned rank transform (ART) procedure for hypothesis testing. For non-normal distributed data, the ART procedure is more robust and powerful than the traditional analysis of variance (ANOVA)”

超訳すると「データが正規分布に従わなかったので、aligned rank transform (ART) を使って検定やった。非正規分布のデータなら、ARTを使ったほうが普通の分散分析よりロバストでパワフルだ」。

ART について、ネット上で検索してもほとんど日本語の情報がありません。かろうじて「整列ランク変換」という訳語が見つかるくらいです。そこで少し調べてみました。

ART法はタイプIエラーをコントロールできるエクセレントな方法だ。研究者がやりがちな古典的分散分析と比べてパワーがある(Mansouri, et al. 2004)

ART はどんな分布のデータにも使えるわけじゃないけど、ロバストだし一般的なノンパラメトリック検定より望ましい性質を持っている(Higgins, et al. 1990)

ART 検定はパワフルでロバストで使いやすい(Mansouri 1998)

交互作用を調べるとき、いくつかの仮定が成り立たない場合、パラメトリックな分析は必ずしもよいわけではない。代替の策として、調整ランク変換検定(adjusted rank transform test)がある。それはパラメトリックな手法とノンパラメトリックな手法の中間みたいなものだ(Leys & Schumann 2010)

つまり、分散分析したい、特に交互作用に注目したい時にデータが正規分布に従わない場合、従来の分散分析は(厳密には)使えないので、整列ランク変換を施してから分散分析すればいいよ、ということだと思います。

R パッケージがないか探したところ、ARTool というものがちゃんとありました。CRAN に登録されています。使い方もカンタン。以下、ART を使った分散分析の方法です。例題として、性別と世代の不倫の許容度に対する違い・交互作用を見たいとします。応答変数は「結婚していても場合によっては不倫を許せる?(1:許せない~4:許せる)」です。4件法でスミマセン。

0.データの分布の確認

ggplot(rensyu, aes(furin)) + geom_histogram(fill = "red", alpha = 0.7, binwidth = 0.5)

あきらかに正規分布には従わないっぽい。もちろん、正規性の検定はすべきですが、ここでは飛ばします。

1.ARTool を使えるようにする。

install.packages("ARTool") # 1回のみでOK。 library(ARTool)

2.データを整列ランク変換する。

henkan = art(furin ~ nendai*sex, data = rensyu) summary(henkan)

art() で変換しますが、式はよくあるタイプです。式は「art(furin ~ nendai + sex + nendai:sex, data = rensyu)」を短縮した書き方にしています。どちらでもOK。lm() のときと同じです。

変換後、summary(henkan) の出力結果に注意します。すべての数値が0になっていることが望ましいです。今回は残念ながらそうならなかったので、警告が出ています。しかし、練習なので先に進めます。

## Warning in summary.art(henkan): F values of ANOVAs on aligned responses not ## of interest are not all ~0. ART may not be appropriate. ## Aligned Rank Transform of Factorial Model ## ## Call: ## art(formula = furin ~ nendai * sex, data = rensyu) ## ## Column sums of aligned responses (should all be ~0): ## nendai sex nendai:sex ## 0 0 0 ## ## F values of ANOVAs on aligned responses not of interest (should all be ~0): ## Min. 1st Qu. Median Mean 3rd Qu. Max. ## 0.0000000 0.0000000 0.0000000 0.0144000 0.0007531 0.0854000

3.分散分析を実行する。

anova(henkan) ## Analysis of Variance of Aligned Rank Transformed Data ## ## Table Type: Anova Table (Type III tests) ## Model: No Repeated Measures (lm) ## Response: art(furin) ## ## Df Df.res F value Pr(>F) Sum Sq Sum Sq.res ## 1 nendai 4 1261 3.7856 0.0045704 ** 1935456 161178877 ## 2 sex 1 1261 100.7097 < 2.22e-16 *** 10944212 137033949 ## 3 nendai:sex 4 1261 4.6317 0.0010275 ** 2369093 161247964 ## --- ## Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1

「anova(変換したデータ)」でOK。実際には、anova.art() が動いて、デフォルトでタイプ3の分散分析をやってくれます。世代と性別の主効果、交互作用は有意になりました(なお、効果量 は世代がほぼ0、性別が0.02、交互作用が0.01でほとんどインパクトはありません)。いちおう、交互作用のグラフをプロットします。

library(ggplot2)

ggplot(rensyu) +

aes(x = nendai, color = sex, group = sex, y = furin) +

stat_summary(fun.y = mean, geom = "point", size = 2) +

stat_summary(fun.y = mean, geom = "line", size = 1) +

xlab("世代") + ylab("不倫の許容度") +

scale_colour_discrete(name ="性別")

伝統的な分散分析と結果を比べてみる。

aaa = lm(furin ~ nendai*sex, data = rensyu) library(car) Anova(aaa, type="III") ## Anova Table (Type III tests) ## ## Response: furin ## Sum Sq Df F value Pr(>F) ## (Intercept) 224.03 1 535.4585 < 2e-16 *** ## nendai 2.39 4 1.4269 0.22278 ## sex 2.22 1 5.3061 0.02141 * ## nendai:sex 3.02 4 1.8051 0.12541 ## Residuals 527.59 1261 ## --- ## Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1

同じくタイプ3でやってみましたが、こちらでは世代の主効果と交互作用が有意になりませんでした。いい感じに対比できましたが、データが怪しいので、結果はあくまで参考用として受け取ってください。

まとめ

整列ランク変換を利用した分散分析では交互作用が有意になった。

ただし、今回のデータはちゃんと整列ランク変換できてはいないのでなんとも言えない。

今後、データが正規分布に従わない場合、使ったほうがよい手法かもしれない。

さいごに

多重比較もできます。繰り返しのデータも分析可能のようです。詳しくはパッケージ作者の Github ページを参考にしてください。今後、必要あれば、使っていきたい分析法です。

参考文献

ARTool パッケージ

https://github.com/mjskay/ARToolFeys, J. (2016). Nonparametric Tests for the Interaction in Two-way Factorial Designs Using R. The R Journal, 8(1), 367-378.

Heidenreich, S., Wittkowski, K., Handrich, M., & Falk, T. (2015). The dark side of customer co-creation: exploring the consequences of failed co-created services. Journal of the Academy of Marketing Science, 43(3), 279-296.

Higgins, J. J., Blair, R. C., & Tashtoush, S. (1990). The aligned rank transform procedure.

Leys, C., & Schumann, S. (2010). A nonparametric method to analyze interactions: The adjusted rank transform test. Journal of Experimental Social Psychology, 46(4), 684-688.

Mansouri, H. (1998). Multifactor analysis of variance based on the aligned rank transform technique. Computational statistics & data analysis, 29(2), 177-189.

Mansouri, H., Paige, R. L., & Surles, J. G. (2004). Aligned rank transform techniques for analysis of variance and multiple comparisons. Communications in Statistics-Theory and Methods, 33(9), 2217-2232.

Wobbrock, J.O., Findlater, L., Gergle, D. and Higgins, J.J. (2011). The Aligned Rank Transform for nonparametric factorial analyses using only ANOVA procedures. Proceedings of the ACM Conference on Human Factors in Computing Systems (CHI ‘11). Vancouver, British Columbia (May 7-12, 2011). New York: ACM Press, 143-146.

目を通してないけど、重要そうな文献

Salter, K. C., & Fawcett, R. F. (1993). The ART test of interaction: a robust and powerful rank test of interaction in factorial models. Communications in Statistics-Simulation and Computation, 22(1), 137-153.

Sawilowsky, S. S. (1990). Nonparametric tests of interaction in experimental design. Review of Educational Research, 60(1), 91-126.

ggdendro と PAC 分析を使ったサービス学会の発表

2017年3月28日(火)、広島県情報プラザというところで開催されたサービス学会第5回国内大会に参加してきました。仕事以外で広島に滞在したのは小学校の修学旅行ぶりです。

http://ja.serviceology.org/events/domestic2017.html

今回は研究をスタートし始めたばかりのネタで、調査・分析が進んでおらず、いろいろと参加者と相談したいという理由で、ポスター発表にしました。

PAC 分析というものを用いたのですが、この分析法ではデンドログラムを使います。せっかくなので、ggdendro を使ってみようと直前までポスターをいじっていました。PAC分析の手法についてはこちらを参照してください(ネット上にもたくさん情報はあります)。

- 作者: 内藤哲雄

- 出版社/メーカー: ナカニシヤ出版

- 発売日: 2003/04

- メディア: 単行本

- クリック: 10回

- この商品を含むブログ (3件) を見る

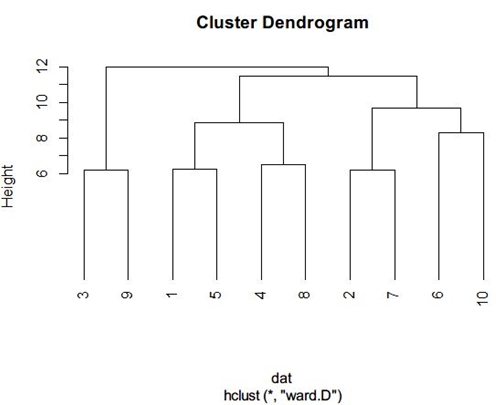

R で普通にクラスター分析するとこんな感じ。

ポスターを作るときはこれをパワーポイントに貼り付けて、回転させてトリミングして整えていきますが、ちょっと色合いがさみしい感じ。私のポスターは茶系で地味なので、ちょっと色がほしかったのです(ggplot のあのグレーが好き)。

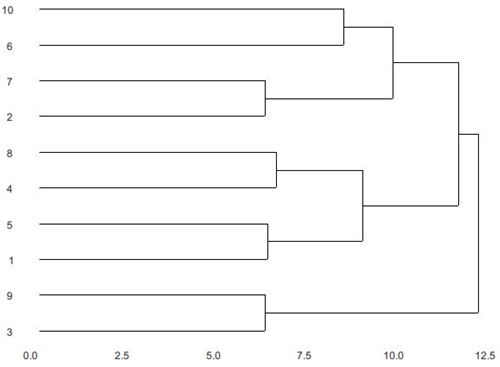

というわけで、ggdendro を使うことにしました。何もしないと ggdendro は背景色が白です。

ここから ggplot2 に持って行き、縦軸と横軸を消していきます。例によって、kazutan 先生の資料を参考にしました。

https://rpubs.com/kazutan/ggdendro_test

できあがりはこちら。ggplot っぽくなりました。

1行目で ggplot に渡すデータを作り、5行目でデンドログラムを横倒しにして、6~8行目で縦軸と横軸を削除しています。あとはこの図をパワーポイントに持っていき、情報を追加したら完成。

いつも直前にホテルでかんづめして作ってます。

ちなみに、A0サイズで7000円ほどかかりました。高いけど、直前まで出力を受け付けてくれたキンコーズ広島本通店さん、ありがとう。

統計的因果推論の勉強会 第3回を開催しました!

最近,ブログは月1更新。仕事と学生はなんとか両立できていると信じたい・・・。

さて,先日,「経営学系統計学エンドユーザー*1のための統計的因果推論 勉強会」第3回を実施しました。これで3回目。クローズド*2。

今回の内容は宮川本と星野本の第3章です。宮川本はパス解析,星野本は傾向スコアについて。星野本は核心に入ってため,難しく,一気に第3章全部はつらいため,60〜69頁をやりました。数式が増えて,本当につらい。

宮川本は構造方程式モデリング(SEM)の話を中心に組んでみました。みんなが SEM に慣れているわけではないので3つ実例を見ながら進行。また,みかけの相関と選択バイアスについても復習をしました。

ちなみに因果ダイアグラムを用いたみかけの相関と選択バイアスについては『岩波DS Vol.3』の中の「相関と因果と丸と矢印のはなし はじめてのバックドア基準」が感動的にわかりやすいです。これは次回の勉強会でみんなで読んでみようと思っています。

- 作者: 岩波データサイエンス刊行委員会

- 出版社/メーカー: 岩波書店

- 発売日: 2016/06/10

- メディア: 単行本(ソフトカバー)

- この商品を含むブログ (3件) を見る

スライドはこちらです。

なお,星野本第3章の詳解は↓に載っています。私にはかなり難しくて,理解が厳しい・・・。

d.hatena.ne.jp

また,こちらのブログ「調査観察データにおける因果推論」のシリーズも詳しく解説されています。

smrmkt.hatenablog.jp

星野本でやれることはやったと思い,『岩波DS Vol.3』を読み直してみるのがいい気がしてきました。次回は岩波DSを題材にもう少し傾向スコアについて勉強を進めていこうと思います。

統計的因果推論の勉強会の1回目を開催しました!

2016年5月28日に統計的因果推論のクローズドな勉強会を開催しました。参加者は5名でした。私を含め全員が非専門家ですので「学び合い」がキーワードです。

対象は下のスライドにあるとおり,経営学を学ぶ統計学エンドユーザーです。進行は,私が宮川本と星野本を1章ずつまとめたものを発表し,それについて不明点の質疑応答を行うというようにしました。印象としては,潜在反応モデル/反実仮想モデルが腑に落ちるかどうかが重要のようです。

www.slideshare.net

やはり,こういうのは発表する人がいちばん勉強になるような気がします。いろいろと質問を受けて,刺激にもなりました。2冊とも第1章はガイダンスみたいなものなので,本番は翌月の第2章からです。来月もがんばります。

サービス学会 国内大会 第4回@神戸に参加してきました

ここ最近、統計の勉強そっちのけでずっと参加報告ばかりですが、そういう時期なんです…。2016年3月28~29日に神戸大学で開催されたサービス学会第4回国内大会に参加しました。実際に参加したのは29日だけです。本当は2日間にしたかったんですが、仕事やら何やらで1日に…。社会人学生あるあるです。

今回のサービス学会 国内大会の概要はこちら。

http://ja.serviceology.org/events/domestic2016.html

サービス学会はマーケティング学会と同様、実務家がとっても多いです。なので、社会人学生*1も参加しやすい。発表もいろいろ。完全に数理なものもあれば、現場密着の発表もあります。分野も幅広い。どちらかというと工学系が多いですが、経営系もがんばっています。大会プログラムは誰でも見ることができるので、見てみてください。

個人的には、ポスター発表が好き。直接いろいろと質問できるので。自分のフィールドの歯科医院に関する研究がいくつかあったのは驚きでした。自分くらいしかやってないだろうと思っていたので。

なお今回参加して、いちばん印象に残ったのが、学会長がいちばん前の席に座って積極的に質問をされていたことです。これは学会長より年下の自分が後ろの席でこそこそ聞いている場合ではないな、と反省した次第。今年度はがんばります…。

*1:まあ、実務家ですから当たり前なのですが。